原文:Advancing AI theory with a first-principles understanding of deep neural networks

作者:FaceBook AI

译者:Hugo

18 世纪末到 19 世纪初,英国人瓦特改良了蒸汽机,这也为工业革命提供了动力,并彻底改变了制造业。接下来的一个世纪,热力学定律和统计力学原理得到发展,科学家们才能够在理论层面上全面解释蒸汽机的工作原理和工作过程。

当然,缺乏理论理解并没有阻止人们对蒸汽机的改进,热机原理的发现促使这些改进更加迅速。当科学家们掌握了统计力学之后,很快就制造出了更好、更高效的发动机。统计力学使人们认识到物质是由原子构成的,它是量子力学的发展起源,甚至也推动了我们今天使用的为计算机提供动力的晶体管的发展。

如今,人工智能正处于类似的关头。深度神经网络 (DNNs) 是现代人工智能研究的一部分,从某种角度来说,它目前也是一个 “黑盒子”。

尽管人工智能从业者取得了重大进展,但业界普遍认为 DNNs 过于复杂,无法从基本原理来解释。目前的神经网络模型在很大程度上是通过反复试验来调整的,虽然反复试验可以通过多年的经验进行,但却没有任何统一的理论语言来描述 DNNs 及其功能。

现在,我们即将出版《深度学习理论原理:理解神经网络的有效理论方法》(The Principles of Deep Learning Theory An Effective Theory Approach to Understanding Neural Networks)一书,该研究由 Facebook AI 研究院的 Sho Yaida、麻省理工学院和 Salesforce 的 Dan Roberts 以及普林斯顿的 Boris Hanin 共同完成。

Sho Yaida、Dan Roberts、Boris Hanin

这本书提供了一个理论框架,从第一性原理来理解 DNNs。对于人工智能从业者来说,这种理解可以显著减少训练这些 DNNs 所需的试错次数。例如,它可以揭示任何给定模型的最佳超参数,而不需要经历大量的时间和计算密集型实验。

《深度学习理论原理》将于 2022 年初由剑桥大学出版社出版,手稿现已公开(在 “数据实战派” 后台回复关键词 “DNN”,即可获得 pdf 下载地址)。

斯坦福大学物理学教授 Eva Silverstein 说:“这本书提出了一种基于理论物理学中常见的扩展机器学习方法。看到这些方法在理解和改进人工智能方面的应用,将是一件令人兴奋的事情。”

这只是重塑人工智能科学漫漫长路的第一步,这一项目既源自第一性原理,同时也专注于描述现实模型的实际工作方式。

如果成功的话,这种关于深度学习的普遍理论可能会让更强大的人工智能模型成为可能,甚至可能指导我们建立一个研究智能的普遍方面的框架。

相互作用的神经元

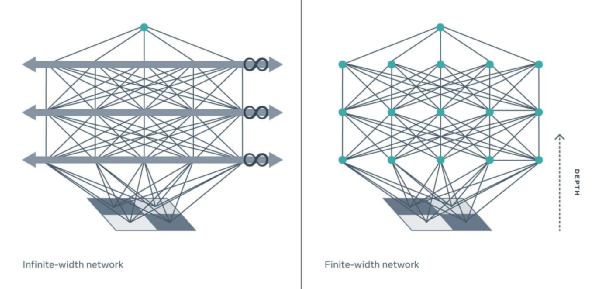

到目前为止,试图理解 DNNs 的理论家通常将这种网络理想化,他们假定 DNNs 的模型每层有无限数量的神经元,即所谓的无限宽度限制。

就像理想气体定律与真实气体定律一样,无限宽度的假设为理论分析提供了一个起点。但它与现实世界的深度学习模型几乎没有相似之处 —— 尤其是在具有 nontrivial 深度的神经网络中,这一假设将越来越偏离准确的描述。

虽然这种无限宽度的限制有时很有用,但它过于简单,忽略了真正 DNNs 的许多关键特性,而正是这些特性使 DNNs 成为了如此强大的工具。

从物理学家的角度来研究这个问题,《深度学习理论原理》通过提出一个有效的有限宽度 DNNs 理论,改进了这种无限宽度的限制。

传统上,物理学家的目标是尽可能创建最简单、最理想的模型,还需要包含描述现实世界所需的最小复杂性。也就是说,这需要取消无限宽度的限制,并系统地结合所有需要的修正来考虑有限宽度的影响。用物理学的语言来说,这意味着在一层和跨层的神经元之间将微小的相互作用建模。

这些听起来像是很小的改变,但是在现有的模型和书中描述的模型之间的结果是本质上不同的。

想象一下两个台球同向相撞。如果使用一个类似于无限宽度限制的无交互模型来计算结果,你会发现两个台球正好穿过彼此,并沿各自的方向继续运动。但很明显,事实并非如此。两个台球不能占据相同的空间,所以它们会发生互相碰撞。

这些相互作用是防止我们从椅子上掉下来,穿过地板,掉向地心的原因。这些相互作用在现实生活中很重要,它们在物理中很重要,它们对 DNNs 也很重要。

考虑到神经元之间类似的相互作用,这本书的理论发现 DNNs 的真正力量 —— 它们从数据中学习世界的表达能力,与它们的长宽比 (即深度 / 宽度比) 成正比。

这一比率在无限宽模型中为零,因此这些玩具模型无法捕获深度,而且随着 DNNs 深度的增加,它们的描述越来越不准确。相比之下,在有限宽度的神经层中,有效的理论实际上会影响深度 —— 这对表征学习和 DNNs 的 D 至关重要。

“在物理学中,有效场论是理解粒子复杂相互作用的一种严谨而系统的方法,” 麻省理工学院物理学副教授、美国国家科学基金会人工智能和基本相互作用研究所主任 Jesse Thaler 说。

“令人兴奋的是,我们发现了一种类似严谨而系统的方法,可以用于理解深层网络的动态。受这些发展的启发,我期待着物理和人工智能社区之间更富有成效的对话。”

探索人工智能 “黑盒子”

虽然书中描述的框架可以扩展到现代人工智能社区使用的真实世界 DNNs,并为此提供了蓝图,但书本身主要关注的是最简单的深度学习模型 (深度多层感知器),并达到指导的目的。

应用于这种最简单的结构,有效理论的方程可以得到系统的求解。这意味着我们可以对 DNN 在整个训练轨迹上的行为有一个第一性原理的理解。

特别是,我们可以明确地写下一个完全训练过的 DNN 正在计算的函数,以便对新的测试例子进行预测。

有了这个新的有效理论,我们希望理论家们能够推动对神经网络的更深入、更全面的理解。虽然还有很多东西需要计算,但这项工作有可能使该领域更接近于了解这些模型的哪些特定属性使它们能够智能地执行计算。

我们也希望这本书能帮助人工智能社区减少有时会限制当前进展的反复试验。

我们想帮助从业者快速设计出更好的模型,让其发挥更高效、更好的性能,更快的完成训练。特别是,那些设计的 DNNs 将能够在没有任何训练的情况下选择最优的超参数,并选择最优的算法和模型架构以获得最佳结果。

多年来,许多人认为这些问题永远无法得到回答或解释。《深度学习理论原理》表明,人工智能不是一门无法解释的技术,实用的人工智能可以通过基本的科学原理来理解。

从理论走向实践

希望这只是个开始。我们计划继续相关研究,将我们的理论框架扩展到其他模型架构,并获得新的结果。在更广泛的层面上,我们希望这本书能证明理论可以提供对实际利益的真实模型的理解。

在科学技术史上,工程制品往往是最先出现的:望远镜、蒸汽机、数字通信。

解释它的功能和局限性的理论通常是后来才出现的:折射定律、热力学和信息论。”Facebook 副总裁兼首席人工智能科学家 Yann LeCun 说道。

“随着深度学习的出现,人工智能工程奇迹进入了我们的生活,但我们对深度学习的力量和局限性的理论理解仍然是片面的。这是最早致力于深度学习理论的书籍之一,并以连贯的方式列出了最新的理论方法和结果。”

近年来,各种实例应用推动人工智能到了新的高度,我们坚信实践有了理论的支撑可以帮助加快人工智能研究,并可能导致发现领域,正如统计力学推动了信息时代的到来一样,我们对此充满期待。

Reference:

1、https://ai.facebook.com/blog/advancing-ai-theory-with-a-first-principles-understanding-of-deep-neural-networks/

来源: 学术头条