大部分人选择 iPhone 的一大理由就是信息安全,这家公司对于个人隐私的保护一直为人称赞。

最近苹果公司宣布,为了让儿童能够更加安全地上网,他们决定在iOS 15、iPADOS 15、macOS Monterey系统中加入一个可以扫描用户照片的功能,这样还会保护隐私吗?

近日,苹果宣布即将推出一个新功能。为了让儿童能够更加安全地上网,他们决定在iOS 15、iPadOS 15、macOS Monterey系统中加入一个可以扫描用户照片的功能。

扫描上传 iCloud 照片的计划在某些方面与微软的 PhotoDNA 相似,不过苹果的扫描主要是在设备端进行的,处理过的图像会被转换为机器学习所需的参数,在云端与数据集进行匹配,设备端不会知道是否找到了匹配项。

这意味着,当功能推出时,NCMEC CSAM数据库一个版本将会下载到每部iPhone上。

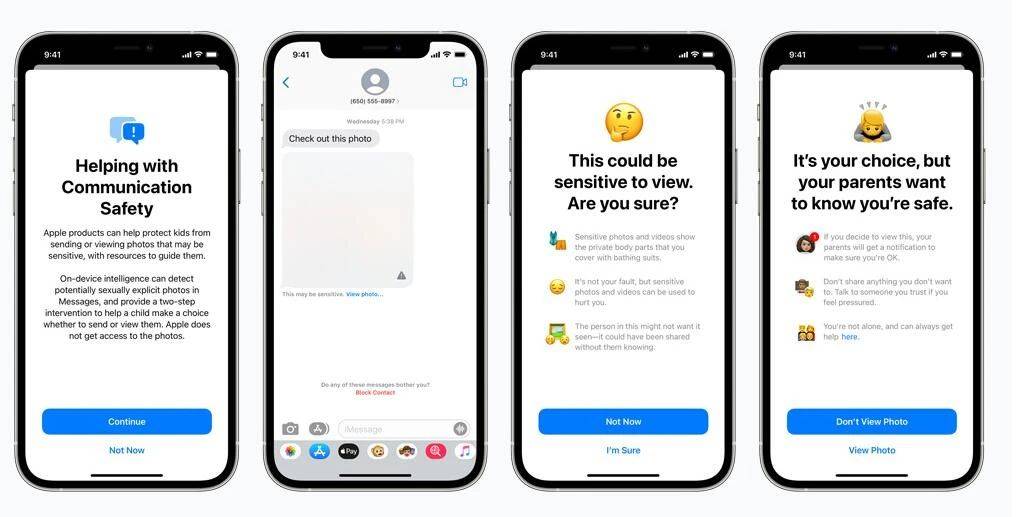

苹果的第二个功能是基于 iMessage 发送或接收的扫描照片的敏感内容通知。为了实施这些通知,苹果将推出一个设备端机器学习分类器,用于检测【色情图片】。

对于年龄在13到17岁之间的用户,将弹出类似的警告通知,但没有家长通知。如果13岁以下的儿童收到 iMessage 认为「色情」的图片,在被允许查看照片之前会弹出一个通知,告诉儿童他们的父母将收到通知。

无论是发送还是接收内容,未成年用户都可以选择在未通知家长的情况下拒绝。

结语

为了消除用户对此系统的顾虑,苹果在公告中说,他们不是为了扫描用户的图片,而是用一种NeuralHash的加密技术,是无法直接看到用户相册的。

NeuralHash是一个可以将图像映射到数字的感知哈希函数,这组哈希值数据库经过加密后存储在苹果设备上,防止用户获取哈希值绕过系统检测。此项技术能够确保相同视觉上相似的图像产生相同的哈希值。例如,稍微裁剪或调整大小的图像是具有相同的哈希值。

想通过技术来保护儿童的苹果,却遭到了网友的热议。

霍普金斯大学教授、密码学家 Matthew Green 对这种系统表示担忧。Matthew Green 说:「这种工具能够可以帮助查找手机中的儿童色情内容,但想象一下,如果掌握权力的公司或机构获得了这种系统,会发生什么?」

相册往往是存有一个人隐私最多的地方,大家都不希望自己的隐私被查看。有网友也会担心,如果有数据泄露……就可怕了。

对于此事,你怎么看呢?

参考链接:

https://www.apple.com/child-safety/

https://www.theverge.com/2021/8/5/22611305/apple-scan-photos-iphones-icloud-child-abuse-imagery-neuralmatch

https://www.eff.org/deeplinks/2021/08/apples-plan-think-different-about-encryption-opens-backdoor-your-private-life

https://www.apple.com/child-safety/pdf/CSAM_Detection_Technical_Summary.pdf

来源: AI科技大本营