在过去的 10 年里,性能最好的人工智能系统——比如智能手机上的语音识别器或谷歌最新的自动翻译器——都是由一种称为「深度学习」的技术产生的。

深度学习实际上是一种称为神经网络的人工智能方法的新名称,70 多年来一直时兴时衰。神经网络最初是由 Warren McCullough 和 Walter Pitts 于 1944 年提出的,这两位芝加哥大学的研究人员于 1952 年搬到麻省理工学院,他们有时被称为第一个认知科学系的创始成员。

神经网络是神经科学和计算机科学的一个主要研究领域,直到 1969 年,根据计算机科学的传说,他们被麻省理工学院的数学家 Marvin Minsky 和 Seymour Papert 「扼杀」了。一年后,Marvin Minsky 和 Seymour Papert 成为麻省理工学院新的人工智能实验室的联合主任。

该技术随后在 20 世纪 80 年代复兴,在新世纪的第一个十年再次陷入衰退,并在第二个十年如火如荼地回归,主要是由于图形芯片处理能力的提高。

麻省理工学院麦戈文脑科学研究所研究员、麻省理工学院大脑、思想和机器中心、麻省理工学院脑与认知科学教授 Tomaso Poggio 说:「有一种观点认为科学中的想法有点像病毒的流行。 显然有五六种基本的流感病毒株,而且显然每一种都会在大约 25 年的时间内回归。人们被感染后会产生免疫反应,因此在接下来的 25 年内不会被感染。然后新的一代,将被同一株病毒感染。在科学中,人们会爱上一个想法,为之兴奋,将其锤死,然后免疫——他们厌倦了它。所以思想应该有同样的周期性!」

重大事项

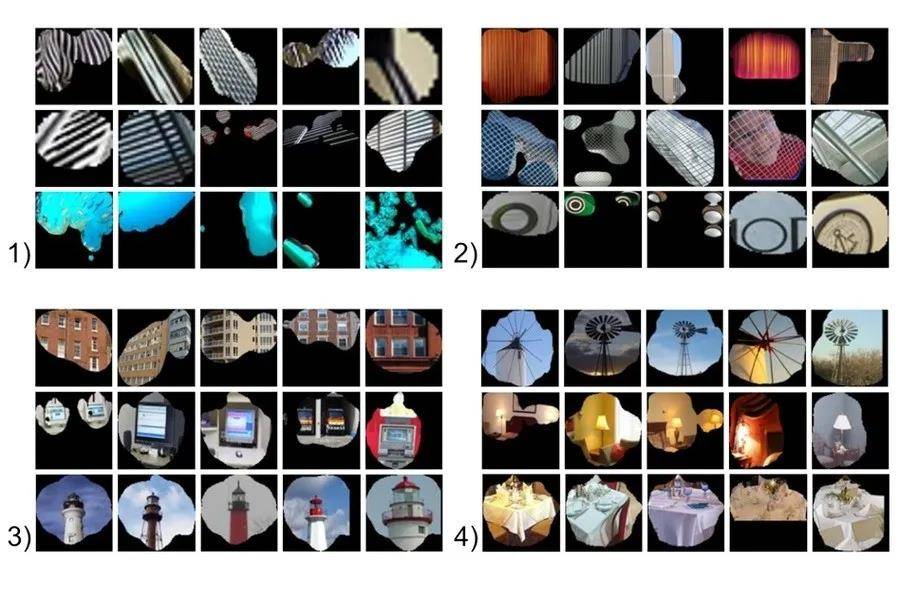

神经网络是进行机器学习的一种手段,计算机通过分析训练示例来学习执行某些任务。通常,这些示例已经预先进行了手工标记。例如,对象识别系统可能会收到数千张带有汽车、房屋、咖啡杯等标签的图像,它会在图像中找到与特定标签一致相关的视觉模式。

神经网络以人脑为模型,由数千甚至数百万个紧密互连的简单处理节点组成。今天的大多数神经网络都被组织成节点层,它们是「前馈」的,这意味着数据只能在一个方向上通过它们。一个单独的节点可以连接到它下面一层的几个节点,从那里接收数据,并连接到它上面一层的几个节点,向那里发送数据。

对于每个传入的连接,节点将分配一个称为「权重」的数字。当网络处于活动状态时,节点在其每个连接上接收不同的数据项(不同的数字),并将其乘以相关的权重。然后将结果乘积加在一起,产生一个数字。如果该数字低于阈值,则节点不会将数据传递到下一层。如果数量超过阈值,则节点「触发」,这在当今的神经网络中,通常意味着沿其所有输出连接发送数字——加权输入的总和。

在训练神经网络时,其所有权重和阈值最初都设置为随机值。训练数据被馈送到底层——输入层——它通过后续层,以复杂的方式相乘和相加,直到最终到达输出层,彻底改变。在训练期间,权重和阈值会不断调整,直到具有相同标签的训练数据始终产生相似的输出。

头脑和机器

McCullough 和 Pitts 在 1944 年描述的神经网络有阈值和权重,但没有分层,研究人员也没有指定任何训练机制。McCullough 和 Pitts 表明,原则上,神经网络可以计算数字计算机可以计算的任何函数。结果是神经科学而不是计算机科学:重点是表明人脑可以被认为是一种计算设备。

神经网络仍然是神经科学研究的宝贵工具。例如,用于调整权重和阈值的特定网络布局或规则,再现了观察到的人类神经解剖学和认知特征,这表明它们捕获了大脑如何处理信息的某些信息。

1957 年,康奈尔大学心理学家 Frank Rosenblatt 展示了第一个可训练的神经网络——感知器。感知器的设计与现代神经网络的设计非常相似,只是它只有一层,权重和阈值可调,夹在输入层和输出层之间。

在 1959 年之前,感知器一直是心理学和计算机科学新兴学科的活跃研究领域,当时 Minsky 和 Papert 出版了一本名为《感知器》的书,该书表明在感知器上执行某些相当常见的计算会非常耗时。

「当然,如果你采用稍微复杂一点的机器——比如两层,所有这些限制都会消失,」Poggio 说。但当时,这本书对神经网络研究产生了寒蝉效应。

「你必须把这些事情放在历史背景下,」Poggio 说。「他们在争论编程——像 Lisp 这样的语言。不久之前,人们还在使用模拟计算机。当时根本不清楚编程要走的路。我认为他们有点过火了,但像往常一样,这不是黑白分明的。如果你认为这是模拟计算和数字计算之间的竞争,他们在为当时正确的事情而战。」

周期性

然而,到 20 世纪 80 年代,研究人员已经开发出修改神经网络权重和阈值的算法,这些算法对于具有不止一层的网络来说足够有效,消除了 Minsky 和 Papert 确定的许多限制,该领域迎来了复兴。

但从理智上讲,神经网络有一些不令人满意的地方。足够的训练可能会将网络的设置修改为可以对数据进行有用的分类,但这些设置意味着什么?对象识别器正在查看哪些图像特征,它如何将它们拼凑成汽车、房屋和咖啡杯的独特视觉特征?查看单个连接的权重并不能回答这个问题。

近年来,计算机科学家开始想出巧妙的方法来推断神经网络采用的分析策略。但在 20 世纪 80 年代,网络的策略难以理解。所以在世纪之交,神经网络被支持向量机取代,支持向量机是一种基于一些非常简洁「优雅」的数学的机器学习替代方法。

最近神经网络的复兴——深度学习革命——得益于计算机游戏行业。当今视频游戏的复杂图像和快速节奏需要能够跟上的硬件,结果就是图形处理单元 (GPU),它在单个芯片上封装了数千个相对简单的处理内核。研究人员很快就意识到 GPU 的架构与神经网络的架构非常相似。

现代 GPU 使 20 世纪 60 年代的单层网络和 20 世纪 80 年代的两到三层网络发展为今天的 10 层、15 层甚至 50 层网络。这就是「深度学习」中的「深度」所指的——网络层的深度。目前,深度学习几乎在人工智能研究的每个领域都为性能最佳的系统负责。

引擎盖下

网络的不透明性仍然令理论家感到不安,但在这方面也取得了进展。除了指导大脑、思维和机器中心 (CBMM) 外,Poggio 还领导该中心的智能理论框架研究项目。最近,Poggio 和他的 CBMM 同事发布了一个由三部分组成的神经网络理论研究。

内容地址:https://cbmm.mit.edu/research/thrusts/theoretical-frameworks-intelligence

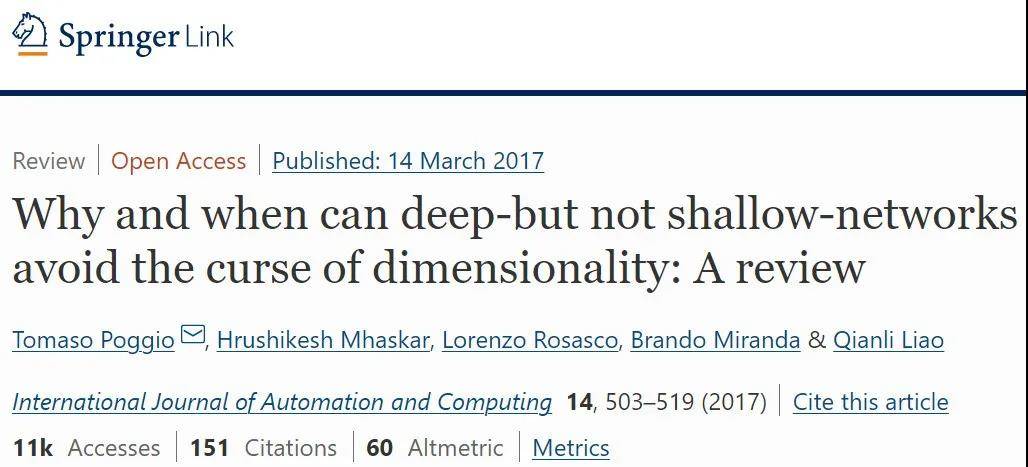

第一部分发表在《国际自动化与计算杂志》(International Journal of Automation and Computing)上,讨论了深度学习网络可以执行的计算范围,以及深度网络何时比浅层网络更具优势。

论文地址:https://link.springer.com/article/10.1007/s11633-017-1054-2

第二部分和第三部分已作为 CBMM 技术报告发布,解决了全局优化问题;或保证网络找到最符合其训练数据的设置、过度拟合;或者网络变得如此适应其训练数据的细节以致无法推广到相同类别的其他实例的情况。

论文地址:http://cbmm.mit.edu/sites/default/files/publications/CBMM-Memo-067.pdf

还有很多理论问题有待回答,但 CBMM 研究人员的工作,可以帮助确保神经网络最终打破使它们在七十年内受到青睐和失宠的世代循环。

参考内容:https://scitechdaily.com/deep-learning-ai-explained-neural-networks/

来源: ScienceAI